CARACTERÍSTICAS DINÁMICAS

Las características dinámicas de un sistema de medida describen su comportamiento ante una entrada variable. Este comportamiento es distinto al que presentan los sistemas cuando las señales de entrada son constantes debido a la presencia de inercias (masas, inductancias), capacidades (eléctricas, térmicas) y en general elementos que almacenan energía.

El tipo de entrada puede ser transitoria (impulso, escalón, rampa), periódica (senoidal) o aleatoria (ruido). La elección de una u otra depende del tipo de sensor.

El comportamiento dinámico de un sensor viene descrito por su función de transferencia. En ocasiones el fabricante no proporciona todas las especificaciones dinámicas ya que la respuesta dinámica del sensor no depende solo de él sino de la forma en que está siendo utilizado.

Error momentáneo: No inmediatez en la respuesta del sistema, lo que ocasiona una diferencia entre el valor esperado en cada momento y el que realmente se produce (no hay cambios en la señal de entrada).

En sistemas cuya entrada varía constantemente, la salida lo hará también pero con un retraso.

Cuando la salida pasa de un valor a otro en un momento dado, se logrará alcanzar el valor final, pero pasado un tiempo.

EVALUACIÓN DE LA RESPUESTA DINÁMICA

Es importante en el ámbito de la Instrumentación la respuesta de un sistema o equipo ante un cambio brusco de la variable de entrada (señal escalón) porque estos incorporan los efectos dinámicos propios del sistema.

Caso ideal…….línea punteada

Respuesta de un sistema ante una entrada escalón

Los sistemas pueden tener muchos tipos de respuestas al escalón, eso depende del orden del numerador y el denominador de su Función de Transferencia.

La mayoría de los casos, la respuesta es similar a la que presentaría un sistema de primer orden o de segundo orden (en el denominador).

Características Dinámicas:

SISTEMAS DE ORDEN CERO:

En un sistema de orden cero se tiene que en la ecuación diferencial no hay derivadas, su respuesta temporal y frecuencial no experimentará cambios.

Ejemplo: Potenciómetro lineal como sensor de posición

Suponiendo que el potenciómetro es ideal la tensión de salida cambia de manera instantánea cuando se desplaza el cursor a lo largo del recorrido del potenciómetro. Debido a las imperfecciones del potenciómetro no se podrá utilizar para la medida de movimientos rápidos.

SISTEMAS DE PRIMER ORDEN:

Los sistemas de primer orden se representan por una ecuación diferencial de primer orden. Contienen un elemento que almacena energía y otro que la disipa.

El término k = 1/a0 es la denominada sensibilidad estática y τ = a1/a0 se conoce como constante de tiempo del sistema.

El parámetro dinámico que representa un sistema de primer orden es su constante de tiempo aunque se pueden definir otros parámetros que también pueden caracterizar lo rápido que resulta un sistema de primer orden como son tr y ts.

Ejemplo: Un termómetro de mercurio o una red RC.

El parámetro dinámico que define un sistema de primer orden es la constante de tiempo, aunque se pueden definir otros parámetros que también permiten caracterizar lo rápido que resulta un sistema de primer orden.

SISTEMA DE SEGUNDO ORDEN:

Un sistema es de segundo orden cuando tiene dos elementos de almacenamiento de energía y otros dos que la disipan, como es el caso de sistemas masa - resorte empleados para la medida de desplazamientos, velocidades y aceleraciones.

La relación entre la entrada X(t) y la salida Y(t) está dada por una ecuación diferencial lineal de segundo orden de la forma:

La respuesta de un sistema de segundo orden a una entrada escalón se obtiene resolviendo la ecuación diferencial de segundo orden o bien, como se ha hecho con los sistemas de primer orden, obteniendo la anti - transformada de Laplace.

En los sistemas de segundo orden, la respuesta ante una entrada escalón no tiene un aspecto único, sino que pueden presentarse tres casos diferentes según la inercia y la amortiguación que presente el sistema, así:

a) Sistemas sobreamortiguados: Sistemas lentos.

b) Sistemas subamortiguados: Sistemas rápidos con oscilaciones.

c) Sistemas con amortiguamiento crítico: Más rápidos que los sobreamortiguados.

Con respecto a la medición y los errores:

- El desarrollo de la tecnología demanda la elaboración de mejores instrumentos y más exactos.

- Entender sus principios de operación para optimizar su uso

- Ninguna medición se puede realizar con una exactitud perfecta.

- Es importante saber cuál es la exactitud real y cómo se generan los diferentes errores en las mediciones.

- Un estudio de los errores es el primer paso al buscar los modos de reducirlos.

- Los errores pueden provenir de diferentes fuentes.

- Si el proceso está en condiciones de régimen permanente existe el llamado error estático.

- En condiciones dinámicas, el error varía considerablemente debido a que los instrumentos tienen características comunes a los sistemas físicos:

-Absorben energía del proceso.

-Esta transferencia requiere cierto tiempo para ser transmitida.

-Retardos en la lectura.

-Este es el llamado error dinámico.

- El error dinámico depende del tipo de fluido, de su velocidad, del elemento primario (termopar, bulbo, etc), de los medios de protección.

Tipos de error:

Los errores se pueden clasificar en tres categorías:

- Errores graves

- Errores sistemáticos

- Errores aleatorios

Errores Graves:

- Son en gran parte de origen humano, como mala lectura de los instrumentos, ajuste incorrecto y aplicación inapropiada.

- Mal registro y cálculo de los resultados de las mediciones.

- Se cometen inevitablemente algunos errores, sin embargo se debe intentar anticiparlos y corregirlos.

- Algunos se detectan con facilidad, pero otros son muy evasivos.

- Principiantes (uso inadecuado de los instrumentos).

Errores Sistemáticos:

Se dividen en dos categorías

- Errores Instrumentales

- Errores Ambientales

Aunque en este grupo podrían incluirse los errores estático y dinámico.

1.

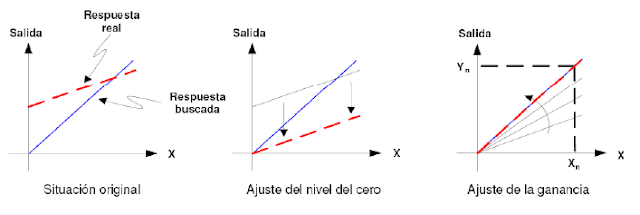

Errores Instrumentales:

- Referentes a los defectos de los instrumentos.

- Por ejemplo aquellos que realizan medición según su estructura mecánica.

- No ajustar el dispositivo a cero antes de tomar la lectura.

- El usuario debe tomar precauciones antes de usar el instrumento.

- Las fallas de los instrumentos se pueden verificar con la estabilidad y la reproducibilidad.

- Comparar con otro de las mismas características.

Estos errores se pueden evitar:

- Seleccionando el instrumento adecuado para la medición particular.

- Aplicando los factores de corrección.

- Calibran el instrumento con un patrón

2.

Errores Ambientales:

- Se deben a las condiciones externas que afectan la operación del dispositivo.

- Efectos del cambio de temperatura, humedad, campos magnéticos.

- Por ejemplo los cambios de temperatura pueden alterar las propiedades elásticas del resorte de un mecanismo y afecta la lectura del instrumento.

- Se pueden corregir evitando esas variables adversas.

Errores Aleatorios:

Se deben a causas desconocidas y ocurren incluso cuando todos los errores sistemáticos se han considerado.