Características Estáticas:

Las características estáticas describen el comportamiento de un sensor o sistema de medida cuando la magnitud a medir permanece constante en el tiempo o varía tan lentamente que se puede considerar constante.

Curva de calibración:

La curva de calibración es la relación entre la entrada al sensor y su correspondiente salida, es decir que la curva de calibración de un sensor o de un sistema de medida en general es la línea que une los puntos obtenidos aplicando sucesivos valores de la magnitud de entrada con sus respectivos valores de salida.

Permiten obtener una relación directa punto a punto de la señal de salida en función de la entrada y viceversa.

Para definir la curva de calibración adecuadamente se necesita como mínimo indicar su forma y sus límites. Estos últimos se especifican con algunos de los siguientes parámetros:

Por ejemplo, si se dispone de un termómetro diseñado para medir entre -20°C y 600°C el campo de medida será

-20°C/60°C.

No linealidad (nonlinearity): Es la máxima desviación de la curva de calibración con respecto a la línea recta por la que se ha aproximado. Habitualmente se suele expresar en forma de % con respecto al alcance. También se conoce como linealidad o error de linealidad.

La linealidad expresa hasta que punto es constante la sensibilidad del sensor.

Zona muerta (dead zone): Es el campo de valores de la variable que no hace variar la indicación, también se define como la región de la curva de calibración que presenta una sensibilidad nula.

Histéresis (hysteresis): Es la diferencia en la medida dependiendo del sentido en el que se ha alcanzado. Un mismo valor de la magnitud de entrada puede provocar salidas diferentes dependiendo del sentido en el que se haya modificado la entrada (creciente o decreciente) hasta alcanzar dicho valor.

Deriva (drift): Es la variación de algún aspecto de la curva de calibración con respecto a algún parámetro ambiental (Temperatura, Humedad) siempre que el parámetro no sea el objeto de la medida.

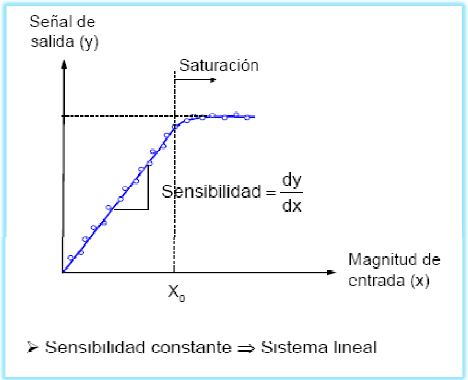

Saturación (Saturation): Nivel de entrada a partir del cual la sensibilidad disminuye de forma significativa.

Resolución (Resolution): La resolución en un dispositivo es el incremento mínimo en la variable de entrada que ofrece un cambio medible en la salida.Un valor en porcentaje sobre el fondo de escala.

Errores:

Diferencia entre el resultado real obtenido y la previsión que se había hecho o que se tiene como cierta. Medir una magnitud con el menor número de errores posibles. Siempre existe un grado de incertidumbre

Para definir la curva de calibración adecuadamente se necesita como mínimo indicar su forma y sus límites. Estos últimos se especifican con algunos de los siguientes parámetros:

- Campo o margen de medida (range): Es el conjunto de valores comprendidos entre los límites superior e inferior entre los cuales de puede efectuar la medida.

Por ejemplo, si se dispone de un termómetro diseñado para medir entre -20°C y 600°C el campo de medida será

-20°C/60°C.

- Alcance o fondo de escala (span, input full scale), FS: Es la diferencia entre los límites superior e inferior de medida.

- Salida a fondo de escala (full scale output, FSO): Es la diferencia entre las salidas para los extremos del campo de medida.

|

| Margen de medida-Alcance |

Sensibilidad (sensitivity):

La sensibilidad es la pendiente de la curva de calibración. Si esta es una recta la sensibilidad es constante y se dice que es el sistema o sensor es lineal.

No linealidad (nonlinearity): Es la máxima desviación de la curva de calibración con respecto a la línea recta por la que se ha aproximado. Habitualmente se suele expresar en forma de % con respecto al alcance. También se conoce como linealidad o error de linealidad.

La linealidad expresa hasta que punto es constante la sensibilidad del sensor.

Zona muerta (dead zone): Es el campo de valores de la variable que no hace variar la indicación, también se define como la región de la curva de calibración que presenta una sensibilidad nula.

Histéresis (hysteresis): Es la diferencia en la medida dependiendo del sentido en el que se ha alcanzado. Un mismo valor de la magnitud de entrada puede provocar salidas diferentes dependiendo del sentido en el que se haya modificado la entrada (creciente o decreciente) hasta alcanzar dicho valor.

Deriva (drift): Es la variación de algún aspecto de la curva de calibración con respecto a algún parámetro ambiental (Temperatura, Humedad) siempre que el parámetro no sea el objeto de la medida.

Saturación (Saturation): Nivel de entrada a partir del cual la sensibilidad disminuye de forma significativa.

Resolución (Resolution): La resolución en un dispositivo es el incremento mínimo en la variable de entrada que ofrece un cambio medible en la salida.Un valor en porcentaje sobre el fondo de escala.

Errores:

Diferencia entre el resultado real obtenido y la previsión que se había hecho o que se tiene como cierta. Medir una magnitud con el menor número de errores posibles. Siempre existe un grado de incertidumbre

- Error absoluto: Diferencia entre el valor medido y el valor exacto en valor absoluto.

- Error relativo: Error absoluto dividido entre el valor exacto.

CUANTIFICACIÓN DEL ERROR (UNE82009-[1-6]) :

- Veracidad (trueness): grado de concordancia entre el valor medio obtenido de una gran serie de resultados y el valor aceptado como referencia. Se suele expresar en términos de sesgo o desviación (bias).

- Precisión (precision): grado de concordancia entre los resultados. Término utilizado para definir la variabilidad entre los resultados. Se cuantifica a partir de los términos de repetitividad (repeatability) y reproducibilidad (reproducibility).

- Exactitud ( accuracy): se refiere conjuntamente a la veracidad y a la exactitud Expresión en términos estadísticos o en porcentaje sobre fondo de escala.

PRECISIÓN -EXACTITUD

|

EXACTITUD-PRECISIÓN

Para definir la variabilidad entre mediciones se tiene la precisión. Diversos factores contribuyen a la variabilidad de un método de medición, entre ellos:

La precisión se cuantifica a partir de dos términos denominados repetibilidad y reproducibilidad.

- El operador que realiza la medición.

- Los equipos.

- La calibración de los equipos.

- El ambiente (T°, humedad, etc).

- El intervalo temporal entre mediciones.

Los términos repetibilidad y reproducibilidad tienen un significado muy parecido, aunque se aplican en diferentes contextos.

- Repetibilidad: Es el grado de concordancia entre los resultados de mediciones sucesivas del mismo mesurando, realizadas bajo las mismas condiciones de medida.

- Reproducibilidad: Es el grado de concordancia entre los resultados de mediciones sucesivas del mismo mesurando, realizadas bajo diferentes condiciones de medida. Las medidas pueden realizarse a largo plazo, por personas distintas, con aparatos distintos o en distintos laboratorios.

CALIBRACIÓN:

Establecer, con la mayor exactitud posible, la correspondencia entre las indicaciones de un instrumento de medida y los valores de la magnitud que se mide.

Las tolerancias de los componentes y las no idealidades de los circuitos electrónicos conducen a que dos sensores o dos instrumentos de medida aparentemente idénticos no presenten nunca curvas idénticas de calibración.

La curva de calibración de los instrumentos varía a lo largo del tiempo y del grado de utilización de los mismos.

Calibración a punto:

Actuar sobre el sistema de medida de forma que para un punto concreto la salida sea lo más exacta posible. Ejemplo:

Las básculas analógicas incorporan un mando para ajustar el cero.

Las básculas digitales lo hacen automáticamente.

La calibración a un punto suele efectuarse sobre el valor cero de la variable de entrada porque suele ser uno de los puntos para los que más fácilmente suele ser conocido el valor verdadero.

Básculas, velocímetros, acelerómetros, medida de desplazamiento.

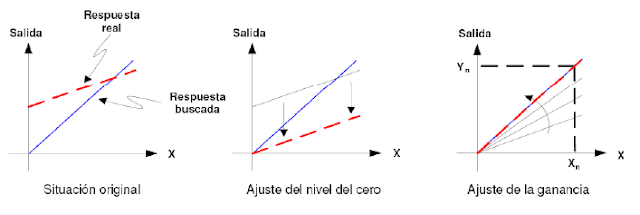

Calibración del cero y de la sensibilidad:

Para ajustar perfectamente una curva de calibración lineal se necesitarían ajustar dos puntos o un punto y la pendiente (sensibilidad).

Algunos instrumentos incorporan esta posibilidad pero sin acceso al usuario, pero sí para el fabricante.

A continuación se muestra los pasos a seguir para un correcto ajuste:

GAMA Y ESCALA:

La gama de un instrumento se define como la diferencia entre la indicación mayor y la menor que puede ofrecer el instrumento. La gama puede estar dividida en varias escalas o constar de una sola. Por ejemplo, el amperímetro de la Fig. a tiene una gama de 0 a 5 mA, y una sola escala, mientras que el de la Fig. b tiene una gama de 0 a 500 mA, dividida en 5 escalas, las cuales van respectivamente de 0 a 0.05 mA; de 0 a 0.5 mA; de 0 a 5 mA; de 0 a 50 mA y de 0 a 500 mA.EFICIENCIA:

La eficiencia de un instrumento se define como la indicación del instrumento dividida por la potencia que absorbe del circuito para poder realizar la medición.

No hay comentarios.:

Publicar un comentario